У детекторов ИИ фото большие проблемы!

Вернее, большие проблемы у нас, коллеги.

Количество моделей для генерации изображений растёт, вместе с ними улучшается базовое качество картинок. Хотя кривых нейрофото от этого меньше не становится, ведь постерами с шестью пальцами и лишними руками грешат даже крупные компании, дальнейшие перспективы далеко не радужные.

Нейросети способны имитировать фотографии на таком уровне, что их становится сложно распознать, не обладая достаточной насмотренностью.

Более того, результаты генерации можно дорабатывать вручную, использовать чудовищные макаронные связи (воркфлоу) в ComfyUI, инпейнт в Fooocus, WebUI Forge и магию Фотошопа, а также смешивать изображения с реальными снимками, обучать и применять LoRa с тонкой настройкой, аккуратно модифицировать проблемные участки, накладывать шумы и текстуры, после чего вылавливать стандартные паттерны становится практически бесполезно.

Особенно сейчас, когда в датасеты, используемые для обнаружения ИИ, периодически попадают «заражённые картинки», частично или полностью созданные с помощью нейронных сетей, а также ложные образцы «ИИ мусора», на самом деле не являющиеся таковыми (например, снимки с сильными артефактами сжатия, эффектом Rolling Shutter, смазанные кадры и фото с выкрученной резкостью, размытые снимки, коллажи).

И тут возникают две очевидные проблемы:

- Детектировать получается только сгенерированные картинки без дополнительной коррекции (и то не всегда!);

- С повсеместным внедрением ИИ плагинов, фильтров и инструментов, в том числе для проявки RAW и обработки JPG, будет расти частота ложных срабатываний.

Детекторы анализируют изображения на наличие пиксельных артефактов, текстурных и структурных особенностей, на распределение шума, на наличие аномалий в анатомии, освещении, перспективе, в распределении оттенков, объектов, цветов, контрастных областей, то есть изучают статистические особенности, характерные для тех или иных моделей нейронных сетей.

Любая модификация с помощью нейронок может привести к тому, что фотография будет помечаться, как сгенерированная с помощью ИИ.

И это та ещё головная боль!

Детекторы демонстрируют процентную вероятность того, что изображение сгенерировано, а не то, насколько оно отредактировано.

Это означает, что подобные платформы будут помечать как изображения, кардинально видоизменённые с помощью генеративной заливки в Adobe Photoshop, отретушированные инструментом «Удаление», модифицированные во Flux и искусственно масштабированные в Topaz Photo AI, так и фотографии без постобработки, к которым применялось только интеллектуальное шумоподавление на этапе проявки RAW.

Для примера приложу два кадра, отправленных на анализ в Decopy AI. Посмотреть на скриншоты с ними можно в конце статьи!

Первый снимок — кадр с художественной ретушью. Он не переделывался с помощью генеративной заливки, вся обработка сделана вручную. Из нейросетевых коррекций тут только шумодав и незначительное повышение резкости, применённые к копии слоя, ослабленной до 37%.

Результат анализа — почти 100% (92,03%) вероятность того, что фотография сгенерирована с помощью ИИ.

Второй снимок значительно видоизменён (примерно на 30-35%).

Модель захотела провести эксперимент, оплатила свои идеи и разрешила использовать готовый кадр в этом посте. Хочу отметить, что изначально я не предполагал, что это займёт столько времени, поэтому в будущем либо откажусь от настолько масштабного редактирования, либо возьму за это впечатляющую сумму денег.

А теперь расскажу о процессе редактирования фото.

Использовал инструмент «Удаление» и генеративную заливку, чтобы поправить фон, отредактировать участки тела, убрать татуировки по просьбе заказчицы. Задействовал Topaz Photo AI и ACR, чтобы повысить резкость, поправить оттенки, сделать картинку чище, затем применил пластику, частотное разложение и Dodge and Burn.

Более того, я использовал несколько кадров, чтобы «пересобрать» снимок, а также сильно отредактировал и нарастил растрёпанные волосы девушки (править пришлось лицо, шею, фон). Для коррекции использовал комбинированный метод ретуши: часть волос поправил вручную (штампом через частотку), часть сгенерировал и дорисовал кистью, проблемные участки доработал «Удалением» и Dodge and Burn.

В качестве финальных штрихов применил тонировку, прошёлся шумодавом, затем наложил зерно через ACR и уменьшил размер кадра до 3500 пикселей перед публикацией в сети.

Шумоподавление помогает сгладить картинку, замаскировать неоднородность текстур и прибрать мелкие артефакты, возникающие после применения инструмента «Удаление» и генеративной заливки в Adobe Photoshop. Неоднородный зернистый шум необходим, чтобы скрыть избыточную пластиковость картинки после подобного сглаживания, а также для того, чтобы создать новые текстуры. В идеале зерно стоит добавлять несколько раз, менять размер, плотность, корректировать для разных участков кадра, особое внимание уделяя коже.

Результат анализа — снимок сделан человеком, вероятность генерации с помощью ИИ — 0,03%.

Несмотря на количество коррекций, в том числе сделанных с помощью нейросетей (тот же инструмент «Удаление» — это 100% нейроретушь), ручная обработка с выравниванием текстур и последующим наложением шума с лёгкостью обманула детектор ИИ коррекций.

Похожий результат получил с помощью 5 рандомных детекторов нейросетевых картинок. Процентная вероятность изменялась, но вердикт везде совпадал.

Я не берусь утверждать, что все проекты ведут себя подобным образом и тем более не гарантирую, что качественная постобработка с наложением шума в несколько итераций поможет обойти распознание паттернов нейросетей для сгенерированных изображений. У эксперимента была другая цель — подсветить проблемы детекторов ИИ, не способных достоверно распознать фотографии, модифицированные с помощью нейросетевых инструментов.

Эксперимент с доработкой изображения подтверждает: сейчас в детекторах ИИ мало смысла, ведь они далеки от абсолютной точности.

Выходом из ситуации может стать внедрение водяных знаков по типу SynthID от Google DeepMind. Однако это поможет автоматически детектировать только базовые изображения, но не спасёт от многоэтапных коррекций и последующих модификаций.

Какие из этого можно сделать выводы?

А хрен его знает!

Если цените естественность, можете отказаться от сложной обработки, выкладывать примеры исходников, оперативно публиковать съёмки и демонстрировать серии снимков. Тренд на натуральность никуда не исчезал (впрочем, как и ценители стильно отретушированных фото), так что подобный подход наверняка найдёт отклик в сердцах клиентов.

В остальных случаях рекомендую забить болт.

Почему?

Ничто не панацея.

Серии снимков? Нейроэнтузиасты уже тренируют LoRa, создают подборки изображений с консистентными телами и лицами. Замена лиц онлайн процветает и множится; фоны, предметы и одежду реально подогнать с помощью Flux Kontext, Flux Fill, SD и SDXL (хотя в последних это доставит изрядно головной боли).

Естественность?

Её можно добиться через осознанное ухудшение картинок, ручное редактирование, монтаж, загрузку референсов, карт глубины и поз, тонировку, создание и использование готовых LoRa, Workflow, имитирующих снимки на полароид, старые мыльницы и фотосессии 90-х. В качестве альтернативы любой желающий (за деньги) может воспользоваться нейросетями по типу Higgsfield, имитирующих селфи на основе загруженных фотографий, генерировать изображения в Flux Pro, Reve, ChatGPT, Ideogram, затем корректировать их в Photoshop…

Конечно, всегда можно сохранять RAW и проявленные исходники, показывать пошаговый процесс обработки, но как по мне, это напрасная трата сил и времени. Если вы не используете ИИ, вам и не нужно ничего доказывать! Используете — в этом тоже нет ничего страшного, ведь нейросети — всего лишь инструмент, а не ужасающее зло.

Вопрос лишь в том, как их применять и подавать результат.

Там, где это допустимо, хоть загенерируйтесь! Например, в творческих экспериментах и при создании референсов для съёмок. Если то, что вы делаете, востребовано у клиентов (от создания спецэффектов до нейроретуши, замены фона, одежды и так далее), то почему бы об этом не рассказывать и не показывать примеры (в том числе до и после)?

Использовать нейросети для ускорения технической ретуши кожи — вполне ок, как и удалять проблемные участки, убирать провода, машины, случайно попавших в кадр людей.

Главное — не используйте нейронки для обмана!

Во-первых, обман рано или поздно вскроется. Во-вторых, если заманивать клиентов 100% сгенерированными снимками, которые вы не можете повторить, это утащит вашу репутацию на самое дно.

Не говоря уже о том, что это неэтично и в целом такое себе. Но что-то я заболтался. Лучше покажу примеры скриншотов, подготовленные для этого поста!

Заинтересовала статья?

Смотрите больше интересных публикаций в моём блоге и Telegram-канале!

Ещё вы можете прочитать новый пост про этичность нейрообработки в ню фотографии, а заодно посмотреть на снимок с последнего скриншота!

Блог

Скопление Гидры (Hydra Cluster, Abell 1060)

Подростковая фотосессия: 5 ключевых особенностей

Фотопроект «Школа магии» в фотостудии Lightroom, Находка

Фотосъёмка Луны с помощью бесплатного онлайн-телескопа

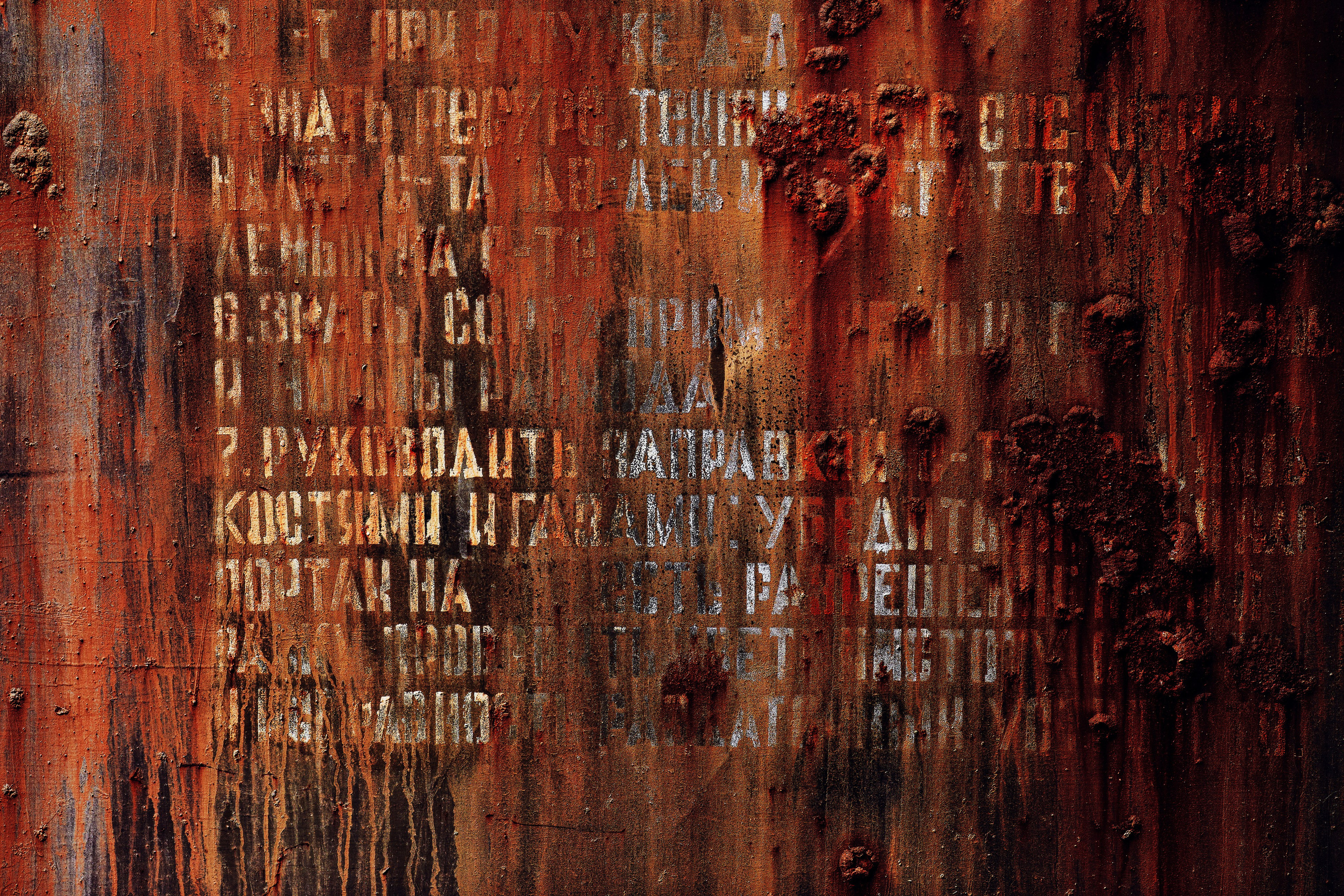

Новая коллекция ржавых фонов и текстур